Linux系统使用ollama本地安装部署DeepSeekR1 + open-webui

1. 首先,下载安装ollama

#下载安装脚本并执行 curl -fsSL https://ollama.com/install.sh | sh #安装完成后查看ollama版本 ollama --version

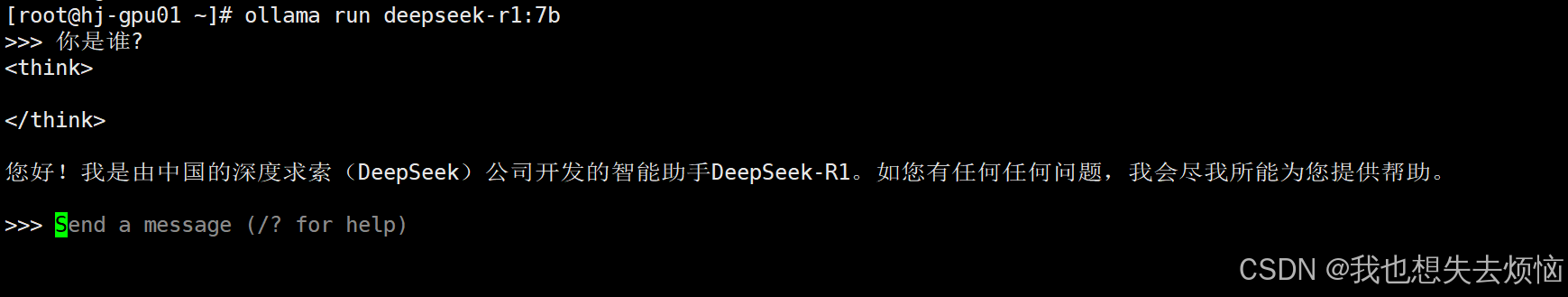

2. 使用ollama下载deepseek

#不同的参数规格对硬件有不同的要求,这里使用7b、个人电脑资源有限可以使用1.5b ollama run deepseek-r1:7b

网络不好执行上面ollama run deepseek-r1:7b命令会非常慢、下载速度会越来越慢

这里提供一个脚本、每隔60s取消然后继续下载(会按照之前下载的进度继续下载)

#!/bin/bash

DeepSeekModel="deepseek-r1:7b"

while true; do

# 判断是否下载完成

DeepSeekModelExist=$(ollama list | grep "$DeepSeekModel")

if [ -n "$DeepSeekModelExist" ]; then

echo "$DeepSeekModel已下载完成"

break

fi

echo "开始下载模型$DeepSeekModel"

# 在后台启动进程

#nohup ollama run $DeepSeekModel >> nohup.log 2>&1 &

ollama run $DeepSeekModel &

# $!获取最近一次在后台执行的进程(即通过在命令末尾添加&符号来使其在后台运行)的进程ID(PID)

processId=$!

echo "进程id为:$processId"

sleep 60

# 检测进程是否存在

if kill -0 $processId 2>/dev/null; then

# 杀死进程

kill -9 $processId

echo "杀死进程、重新下载模型"

else

echo "进程id不存在、模型可能下载完成"

fi

done

3. 下载open-webui

模型下载好之后就可以在命令行中进行对话,但是这样看起来不太好看,我们可以使用开源的open-webui来做展示

这里使用docker安装open-webui

没有docker需要先安装docker

##安装docker #安装依赖 yum install -y yum-utils device-mapper-persistent-data lvm2 #设置阿里云的docker yum源 yum-config-manager --add-repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo #安装docker yum install -y docker-ce docker-ce-cli containerd.io #启动docker并设置开机自启 systemctl start docker systemctl enable docker #查看docker版本 docker --version mkdir -p /etc/docker tee /etc/docker/daemon.json <下载open-webui镜像

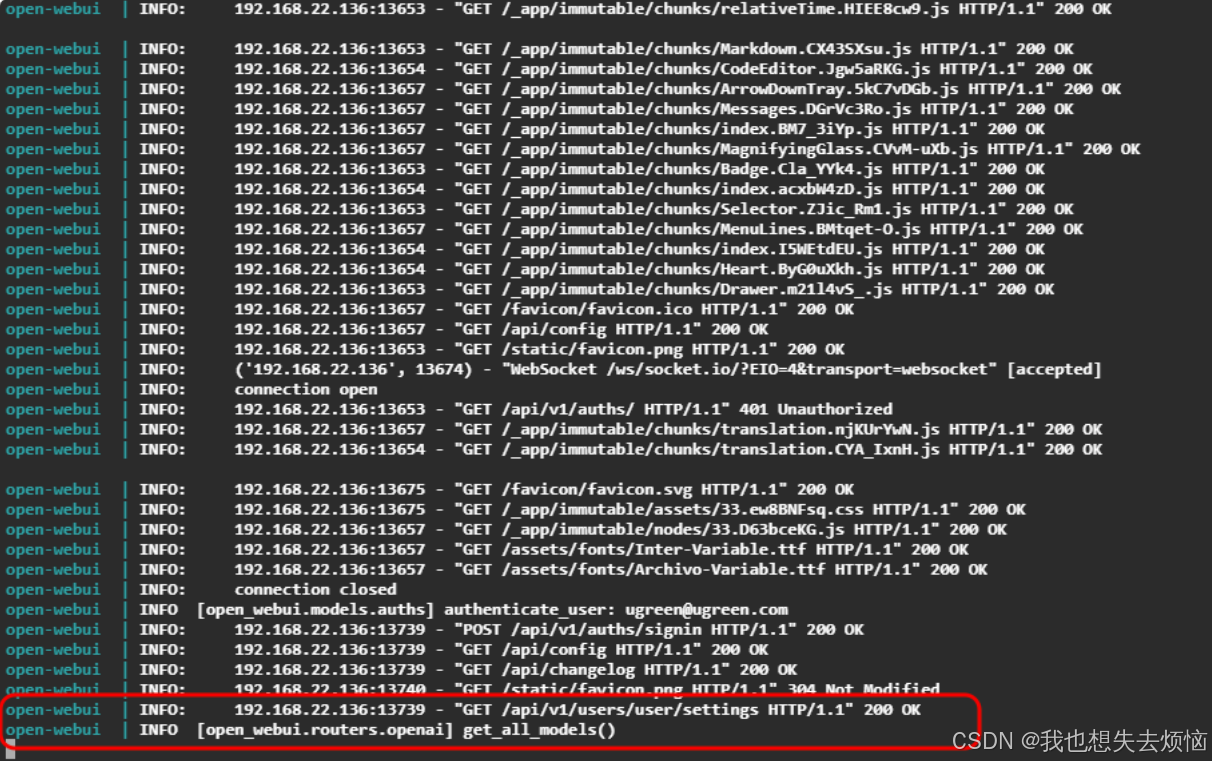

#下载镜像 docker pull ghcr.io/open-webui/open-webui:main #下载完成后、运行容器 docker run -d --network=host -e OLLAMA_BASE_URL=http://127.0.0.1:11434 -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main4. 浏览器访问webui界面

#访问地址 http://ip:8080 #第一次访问时页面加载会很慢、需要耐心等待 #可以查看webui容器日志 docker logs -f open-webui看到get_all_models()是正常的、等待加载即可

然后在页面进行注册登录就可以了,模型选择deepseek-r1:7b 就可以使用deepseek了